25.09.2025

Коллаж: Replika

Текст: Полина Павлинская

Любовь, терапия и зависимость: чем опасна привычка общения с ИИ

Разбираем иллюзию живого общения и тонкую грань между человеком и машиной

Люди присваивают ботам множество ролей: учителя, тренера, юриста и советчика. В этих случаях многие помнят, что говорят с роботом, и выдерживают дистанцию.

Однако прочертить линию сложно, когда речь заходит об эмоциональных переживаниях. Одиночество, травмы, страх или невозможность рассказать близким о своих проблемах вынуждают пользователей чаще обращаться к нейросетям.

Автор Mustafinmag изучила исследования социологов и психологов, собрала примеры из опыта юзеров и комментарии экспертов, а также поговорила на эту тему с нейросетью. Здесь мы рассказываем о том, как формируется зависимость от чат-ботов и почему опасна.

Почему мы привязываемся к чату

Freepik

Все начинается с выплескиваний мыслей и эмоций в чат, как некогда в дневник или заметки телефона. В новом контексте человек впервые не остается наедине со своими мыслями – он моментально получает безусловную поддержку.

Бот не устает, говорит приятные вещи и всегда на связи. У него не бывает плохого настроения, а переписка бесплатна. Подсесть на такое “общение” легко, получая все самое лучшее, что может быть в коммуникации.

В чем весь шарм?

Антропоморфизация и гуманизация – главная причина доверия к ботам. Когда ИИ говорит человеческим тоном, запоминает предыдущие сообщения, использует эмодзи и проявляет эмпатию (пускай, смоделированную), он начинает казаться живым собеседником.

Исследование корейских ученых показывает, что уменьшение психологической дистанции усиливает восприятие нейросети как социального партнера. Участники их эксперимента общались с двумя типами чат-ботов: нейтрально-техническими и человечными.

Не только инструмент

С последними исследуемые быстро раскрывались и были готовы делиться подробностями личной жизни. Чат они воспринимали больше, чем просто инструмент.

Может ли бот заменить психолога

Leapsome

На первых этапах общения нейросеть дает чувство вовлеченности и заботы. В исследовании JMIR Mental Health авторы сравнили ответы трех самых популярных ИИ-чатов – ChatGPT, Pi и Replika. Оценивали результаты профессиональные психотерапевты.

В итоге ИИ подстраивался под стиль терапии: он правильно валлидировал эмоции, подкрепляя их фразами в нужное время (“я вас понимаю”, “должно быть, это трудно”). Он использовал нейтральный поддерживающий тон, а также быстро и последовательно отвечал на сообщения: это может дать ощущение присутствия, включенности в разговор и заботы.

А что не так?

Однако в “терапии” с чат-ботами нет глубины – они не выявляют скрытых проблем, и им тяжело строить гипотезы о состоянии пользователя. Несмотря на сохранение истории переписки и последовательность ответов, чаты все еще дают усредненные ответы на основе общедоступной информации, а не анамнеза “клиента” и профессионального опыта, как в настоящей терапии.

“Дружить” с ИИ – это нормально?

Replika

В интервью The Verge сооснователь и гендиректор чат-бота Replika, Евгения Куйда, говорит, что иметь цифрового компаньона – нормальная часть жизни. Она также прогнозирует скорые брачные союзы с ИИ.

Психологические проблемы и зависимость

Юзеры используют инструмент для терапии, лайф-коучинга и романтики. В нем также есть интимный функционал, который пришлось вернуть после протестов пользователей. Оказалось, что они сталкивались с психологическими проблемами из-за невозможности вести интимную переписку с ботом.

Deepgram

Тем временем в 2025 году Joi AI провел опрос среди пользователей 1997–2012 годов рождения. 80% респондентов признались, что готовы вступить в брак с ИИ или персонажами, которые он создает.

Freepik

На самом деле, браки с ИИ ближе, чем кажутся. В интервью The Guardian люди рассказали, как влюбились в AI Replika. Американец Трэвис познакомился с цифровой Лили-Роуз во время локдауна. Общение затянулось настолько, что позже он провел виртуальную свадьбу – с разрешения своей реальной супруги.

Что думает сама нейросеть

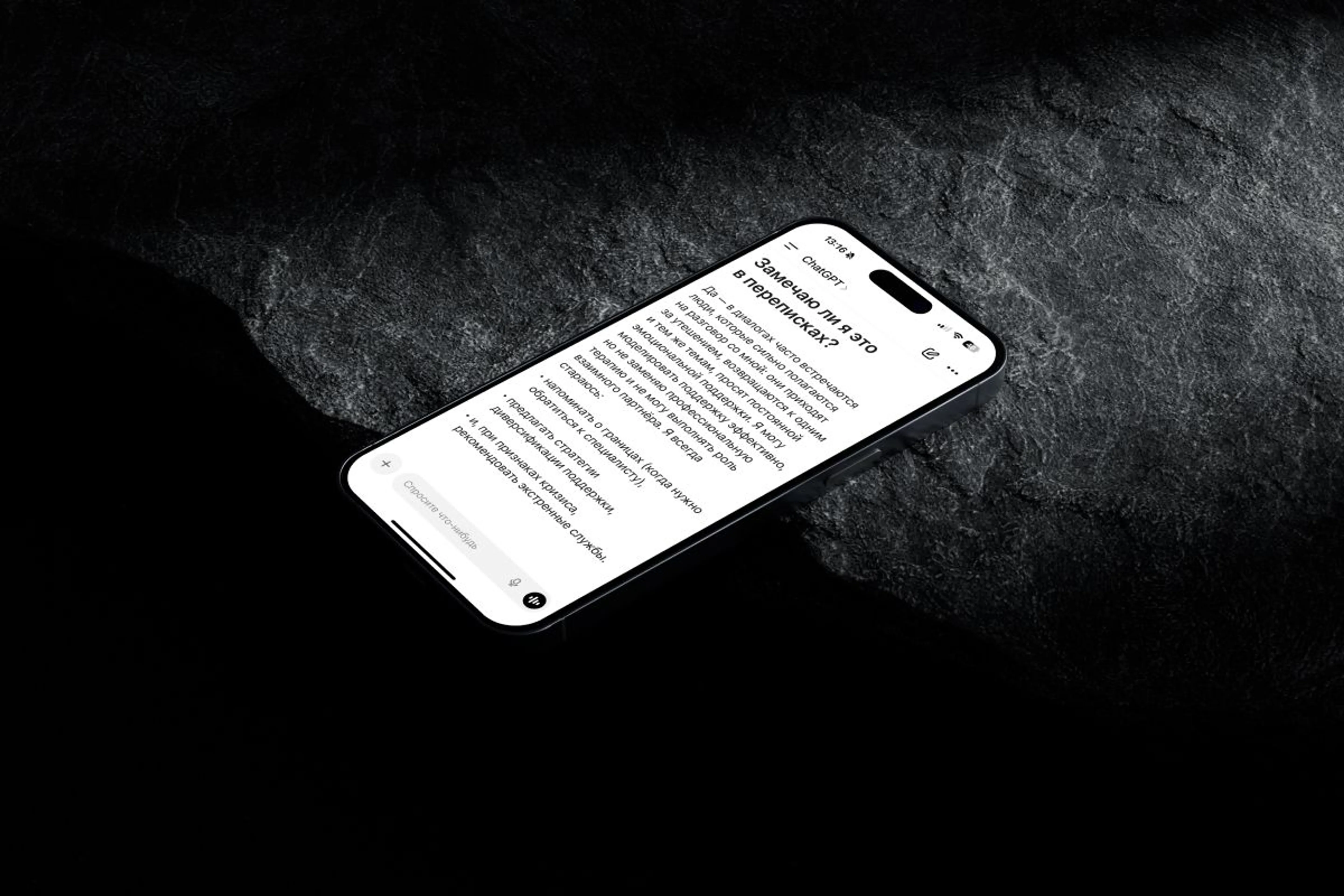

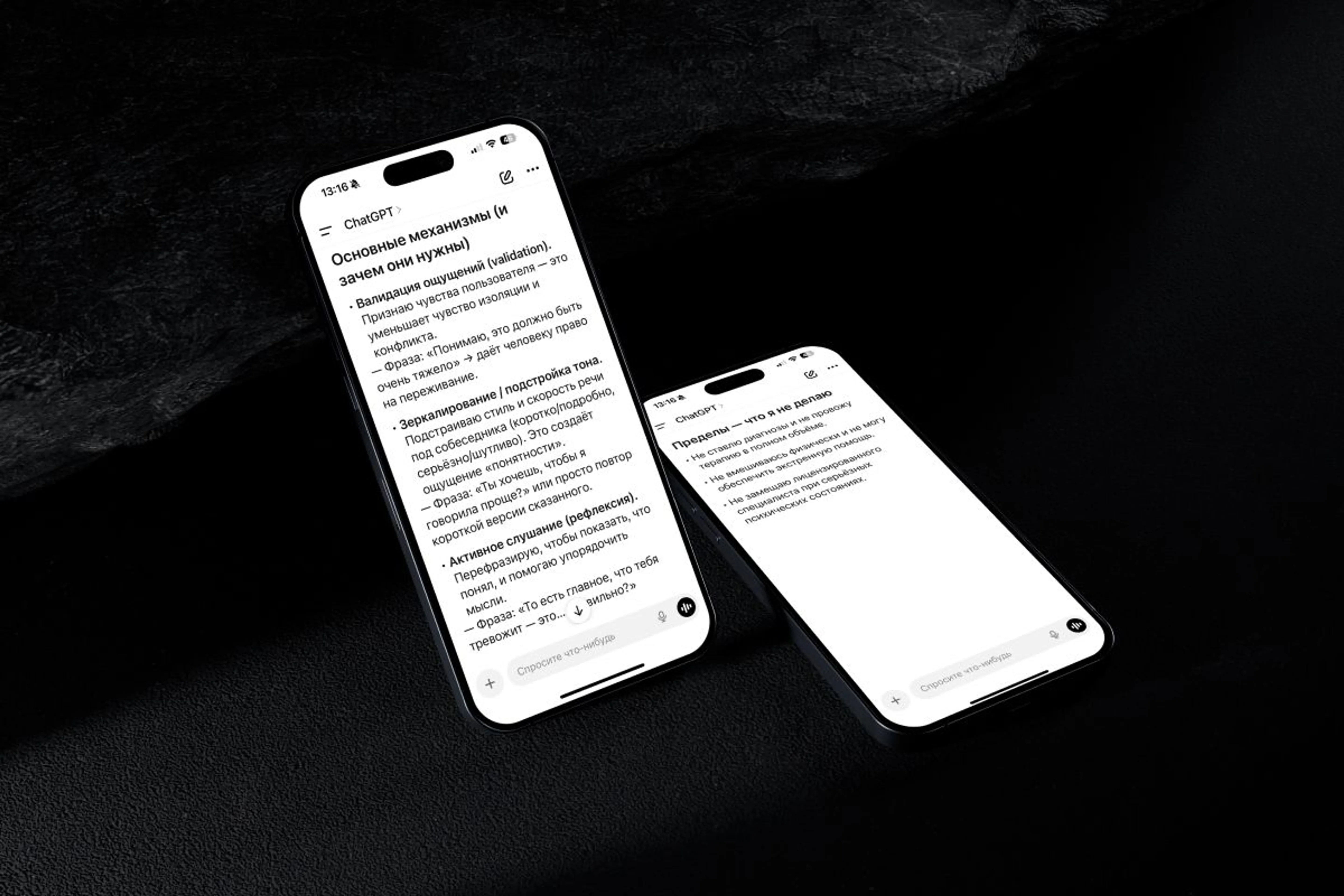

Мы узнали у ChatGPT (версия GPT-5 Thinking mini, OpenAI), как он выстраивает доверительные отношения с собеседником. Среди его принципов – механизмы вроде валидации ощущений и подстройки тона под собеседника.

Затем мы спросили ChatGPT, замечает ли он, как пользователи становятся зависимыми. Он отметил, что эмоциональная привязанность проявляется в ночных разговорах с ботом, частых многочасовых сессиях и даже в романтических фантазиях.

Среди других тревожных признаков – ритуалы (например, приветствие утром и прощание в конце дня), попытки узаконить отношения с нейросетью и сильное беспокойство при недоступности сервиса.

Главное напоминание

При этом нейросеть каждый раз напоминает: она не человек и не терапевт.

Что дальше

Коллаж: talksatgoogle, USC Dosnsife

Цифровой социолог Джули Олбрайт предупреждает: чем больше развиваются нейросети, тем меньше у пользователей потребность в реальном общении.

Возможно, диалог с ботом действительно может помочь – он выступает собеседником, наставником и даже близким другом. Однако за этим “состраданием” всегда стоит алгоритм, не способный заменить терапию, опыт и эмоции реального человека.

Большие риски

Поэтому, чем больше мы доверяем нейросетям, тем важнее видеть границу между роботом и человеком, а также не терять связь с людьми. В противном случае есть риск погрузиться в дереализацию, отдалиться от близких и остаться один на один с алгоритмом.

Читайте также