04.11.2025

Коллаж Mustafin Magazine

Текст: Руслан Абдряев

Суд по подсказке: как ИИ помогает и мешает юристам

Разбираем победы в судах, штрафы за фейки и границы доверия к нейросетям

В конце октября пользователи Reddit заметили, что ChatGPT от OpenAI перестал давать персонализированные ответы по темам юриспруденции и медицины. Теперь чат-бот выдает только общую информацию в образовательных целях без советов и диагностики, отправляя пользователей к лицензированным специалистам.

OpenAI не комментировала изменение своей политики. Однако пользователи считают, что компания просто перестраховывается – слишком много людей начали решать с ИИ свои реальные дела.

В этом материале автор Mustafinmag изучил, как юристы и суды по всему миру уже используют нейросети, и насколько это вообще уместно.

ИИ помогает

nbcnews.com

В октябре Линн Уайт из Калифорнии рассказала, что использование ChatGPT и Perplexity помогло ей выиграть суд по делу о выселении. У женщины были просрочены платежи за дом, а денег на адвокатов не было, поэтому она поручила ботам проанализировать судебные решения и подготовить апелляцию. В итоге суд отменил решение о выселении, аннулировал штрафы и счета по просроченной аренде на сумму свыше $70 тыс.

Другие американцы также поделились позитивным опытом работы с ИИ. Например, житель Нью-Йорка Ричард Хоффманн выиграл суд у бывшего работодателя, а Стейси Деннетт из Нью-Мексико сократила долг на $2000 – тоже благодаря ChatGPT.

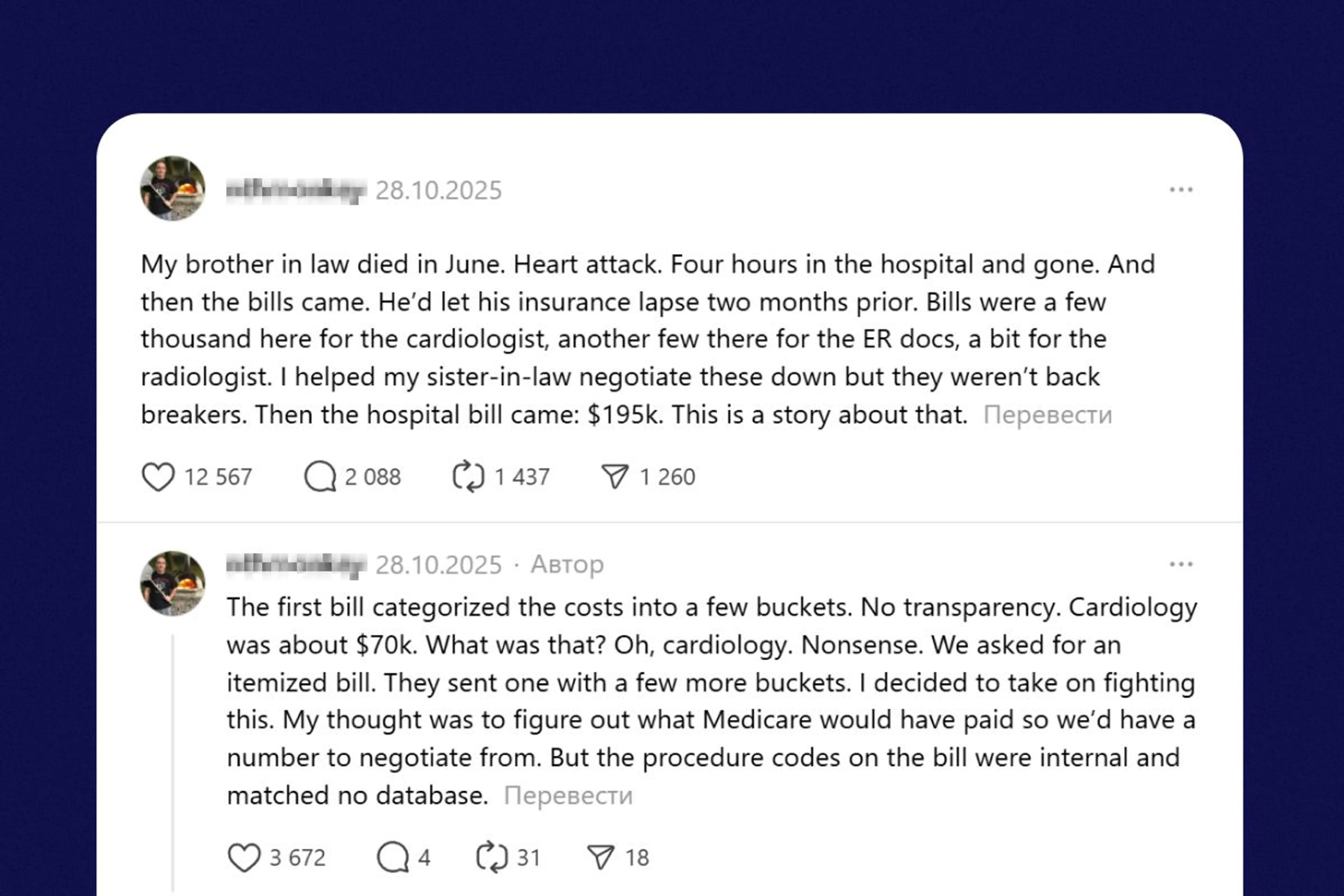

Threads

Кстати, ИИ оказывается полезен не только в юриспруденции, но и в других сферах, требующих работы с крупным массивом данных и наличия квалификации. Например, семья американца Мэтта Розенберга сократила расходы на лечение в больнице со $195 тыс. до $33 тыс. благодаря Claude от Anthropic.

davidrickslaw.com

При этом разработчики ИИ-моделей призывают своих клиентов не полагаться исключительно на их продукты для получения юридических консультаций, хотя технология предлагает широкие возможности в этой области.

По данным Стэнфорда, трое из четырех юристов уже планируют внедрять генеративный ИИ в практику. По результатам другого опроса 72% считают его “силой добра” в профессии.

Некоторые судьи тоже не отстают: британец Кристофер Макналл использовал Copilot от Microsoft, чтобы суммировать материалы дела, а его коллега из Колумбии, Хуан Падилья, консультировался с ChatGPT перед вынесением решения по делу семьи с ребенком, страдающего расстройством аутистического спектра.

Данные: mordorintelligence.com

По прогнозам Mordor Intelligence, рынок ИИ-сервисов для юристов уже превысил $2,4 млрд и вырастет до $4 млрд к 2030 году. Среди популярных инструментов – Harvey AI, CoCounsel и Casetext, которые экономят до 80% времени на анализ документов.

ИИ вредит

Коллаж Mustafin Magazine

Модели на базе ИИ часто страдают от галлюцинаций – отсюда и выдача некорректной информации. Такие ошибки чрезвычайно опасны, если они добираются до судебных документов, поскольку от этого зависят судьбы реальных людей.

Осенью суд Калифорнии оштрафовал адвоката Амира Мостафави на рекордные $10 тыс. за документы, где 21 из 23 цитат оказалась поддельной – все сгенерировал ChatGPT. А летом трое юристов в США получили санкции за использование фейковых ссылок в судебных исках.

Freepik

Подобные ошибки встречались во множестве других дел. По данным 404 Media, только к концу сентября 2025 года насчитывалось как минимум 410 таких случаев по всему миру. Юристы объясняли свои ошибки личными обстоятельствами, собственной недальновидностью и беспечностью, а также требованиями работодателей быть более эффективными. Однако чаще всего они просто винили своих помощников.

При этом ошибаются не только адвокаты, но и судьи. Например, американец Генри Уингейт допустил множество фактических ошибок при вынесении решения по делу из-за галлюцинаций в системе ИИ, которому доверился.

Юристы напоминают: модели не проверяют факты, а лишь генерируют ответы на основе статистических закономерностей, полученных из больших наборов данных. Правила этики работы адвокатов также требуют, чтобы специалисты проверяли данные для судебных исков.

Eric Muller / futurism.com

Из любопытного: в Университете Северной Каролины провели имитационный суд, где присяжными сделали ChatGPT, Grok и Claude. Юристы раскритиковали работу чат-ботов – алгоритмы не понимают языка тела и не могут опираться на человеческий опыт. Но профессор права Эрик Мюллер уверен: ИИ-помощники становятся лучше, а со временем эти проблемы решатся.

Важно

Так или иначе, нейросети будут продолжать проникать в судебную систему. Поэтому, чем умнее становятся алгоритмы, тем важнее людям не терять бдительность – ведь цена ошибки может оказаться слишком высокой.

Читайте также

Слишком много экрана: как бороться с цифровой интоксикацией

Разбираемся, может ли отказ от скроллинга и уведомлений помочь психике

28.01.2026

“Пикантный” ИИ: почему Grok стал фабрикой откровенных дипфейков

15.01.2026